Насколько ужасен баг деиндексации в Google?

5 апреля 2019 года владельцев сайтов и SEO-специалистов настиг неприятный сюрприз — страницы в массовом порядке выпали из индекса Google. Спустя два дня неведения, поисковик всё-таки подтвердил технический сбой и пообещал апдейт, как только все проблемы будут полностью решены:

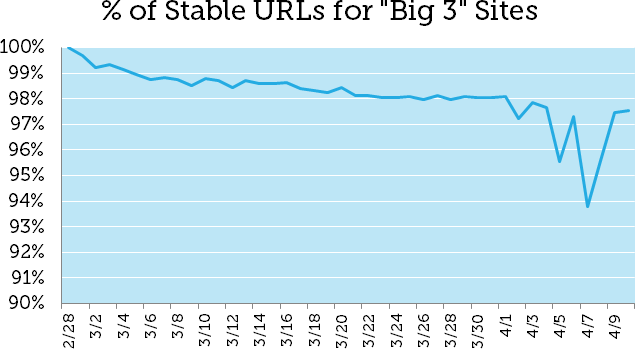

MozCast зафиксировал критическое изменения выдачи 6 апреля и неудивительно — по их данным проблема затронула около 4% всех проиндексированных Google документов. Ниже проверим, как были получены эти данные и насколько вообще серьезны подобные баги.

Можно ли вообще выделить поток деиндексированных страниц?

Инструменты, которые предлагает нам Google позволяют проверить индексацию документов, но для изучения масштаба проблемы не годятся и не дают доступа к истории. Поэтому специалисты в MOZ решили пойти от обратного — выделить пул URL, которые должны довольно стабильно держаться в выдаче, и на их основе определить паттерны необычного отклонения.

В феврале MozCast ежедневно отслеживали 149 043 URL-адреса, твердо закрепивших позиции в ТОП-10 Google. Для надёжности это число сократили до документов, которые:

-

Появлялись на первой страницы SERP каждый день в течение месяца.

-

Запросы, по которым ранжировались страницы, исключали навигационные и брендовые.

-

Минимальная позиция документа в Google — 5.

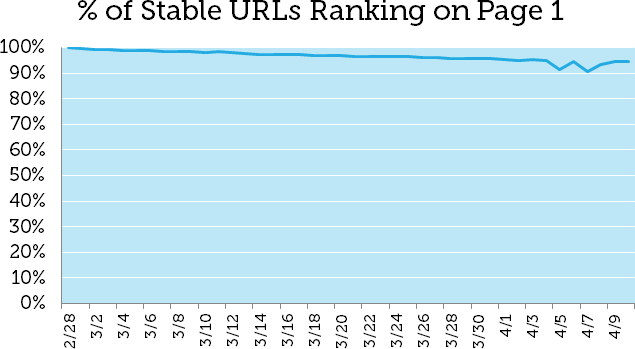

Таким образом было получено 23 237 достаточно «стабильных» адресов. А вот график, показывающий процент анализируемых URL, попадающих на первую страницу в SERP с 28 февраля по 10 апреля.

Как и ожидалось, 28 февраля в ТОП-10 находилось 100% всех адресов, далее следует вполне естественная динамика изменения выдачи, а 5 апреля начались скачки.

Как-то мелко, увеличьте, пожалуйста

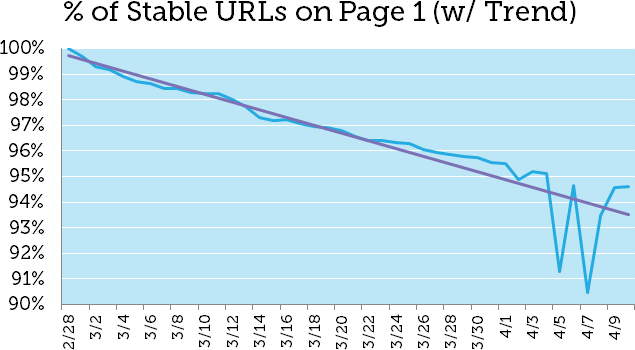

Давайте посмотрим поближе на ось Y и добавим линию тренда (естественного изменения SERP).

Теперь мы видим процент отклонения — 4% с датой 5 апреля, восстановление и снова падение на 4,4% с датой 7 апреля.

Обратите внимание, мартовское обновление основного алгоритма Google практически не повлияло на выборку URL. Это намекает на масштаб неприятности деиндексации.

Что насчёт интента запросов?

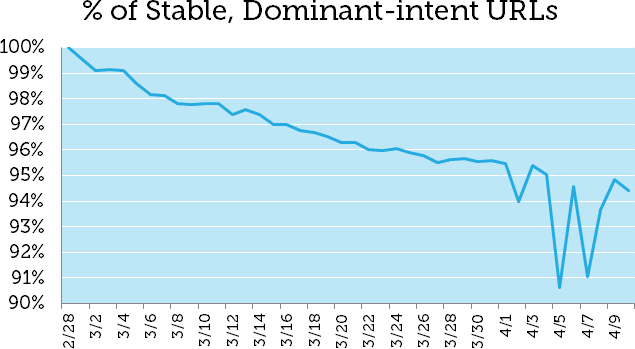

Из анализа выше были намеренно удалены запросы, по которым в выдаче появляются быстрые ссылки в сниппетах (extended sitelinks), поскольку они тесно коррелируют с очевидным интентом пользователей.

MOZ предполагают, что такие запросы могли бы замаскировать общий эффект бага, ведь Google активно инвестирует в повышение качества выдачи именно по ключевикам, предполагающим определённое намерение пользователей.

Но технический сбой коснулся их ничуть не меньше. Вот результаты для 5 064 URL, появляющихся в SERP с быстрыми ссылками в сниппетах.

Абсолютно аналогичная история, и говорит она о массовой деиндексации.

У бага случайный или систематический характер?

Это вопрос без ответа. Вполне возможно, анализ «стабильных» URL может несколько искажать общую картину. Но, к сожалению, измерять отклонения для изначально нестабильных URL довольно бессмысленно.

Также следует подчеркнуть, что для анализа использовались в основном высокочастотные запросы, без длинных хвостов.

Но ведь есть гиганты вроде Wikipedia, Amazon и Facebook («большая тройка»). На их примере можно проследить характер бага.

Снова похожая ситуация и даже такие мегасайты не были защищены. Это говорит скорее о случайности происходящего. Деиндексирование кажется бессистемным и затронуло сайты абсолютно разного масштаба и тематик.

Уже всё в порядке, что дальше?

«Счастливых концов не бывает... Потому что ничто не заканчивается.» Такая фраза звучит в любимом мультфильме («Последний единорог») Питера Дж. Мейерса, резидента MOZ.

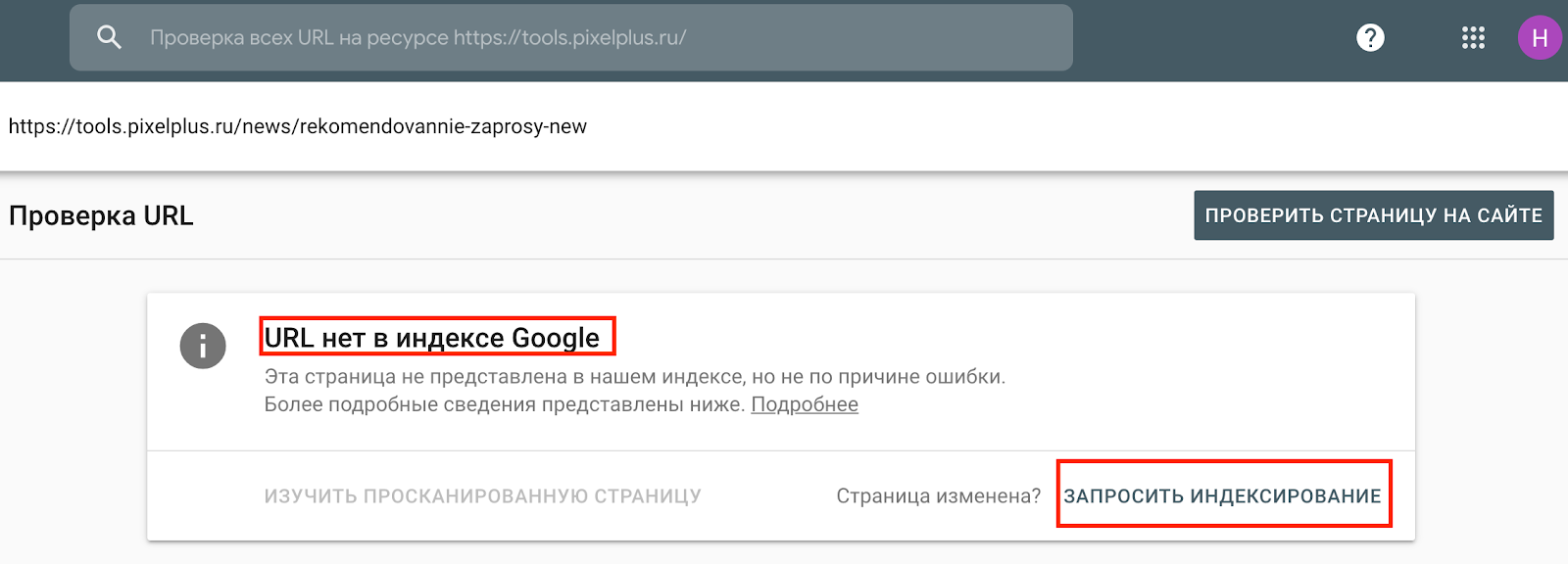

Индексация нормализовалась, но если ваши URL всё ещё не возвращаются в поле зрения Google, нужно идти в Search Console и отправлять адреса на переобход. Это довольно утомительно, поэтому сосредоточьтесь в первую очередь на целевых страницах.

Делается это так:

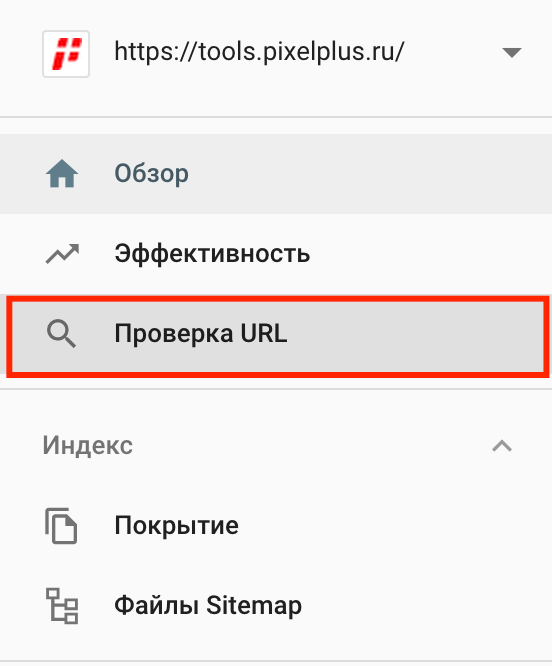

1. Заходим в консоль и переходим на вкладку «Проверка URL».

2. Указываем адрес URL, проверяем наличие страницы в поиске Google и запрашиваем индексацию.

Влияние бага измеримо, если довериться MOZ – 4%. Достаточно много для современных поисковых систем, которые весьма стабильны, но долгосрочные последствия должны быть минимальными. Во всяком случае, Google уверяет, что это всего лишь ошибка, а не преднамеренный эксперимент. Дэнни Салливан заявил, что проблему полностью решили, спустя 6 дней после первого «выпада».

Будем надеяться. Следите за апдейтами и не выпадайте из индекса!

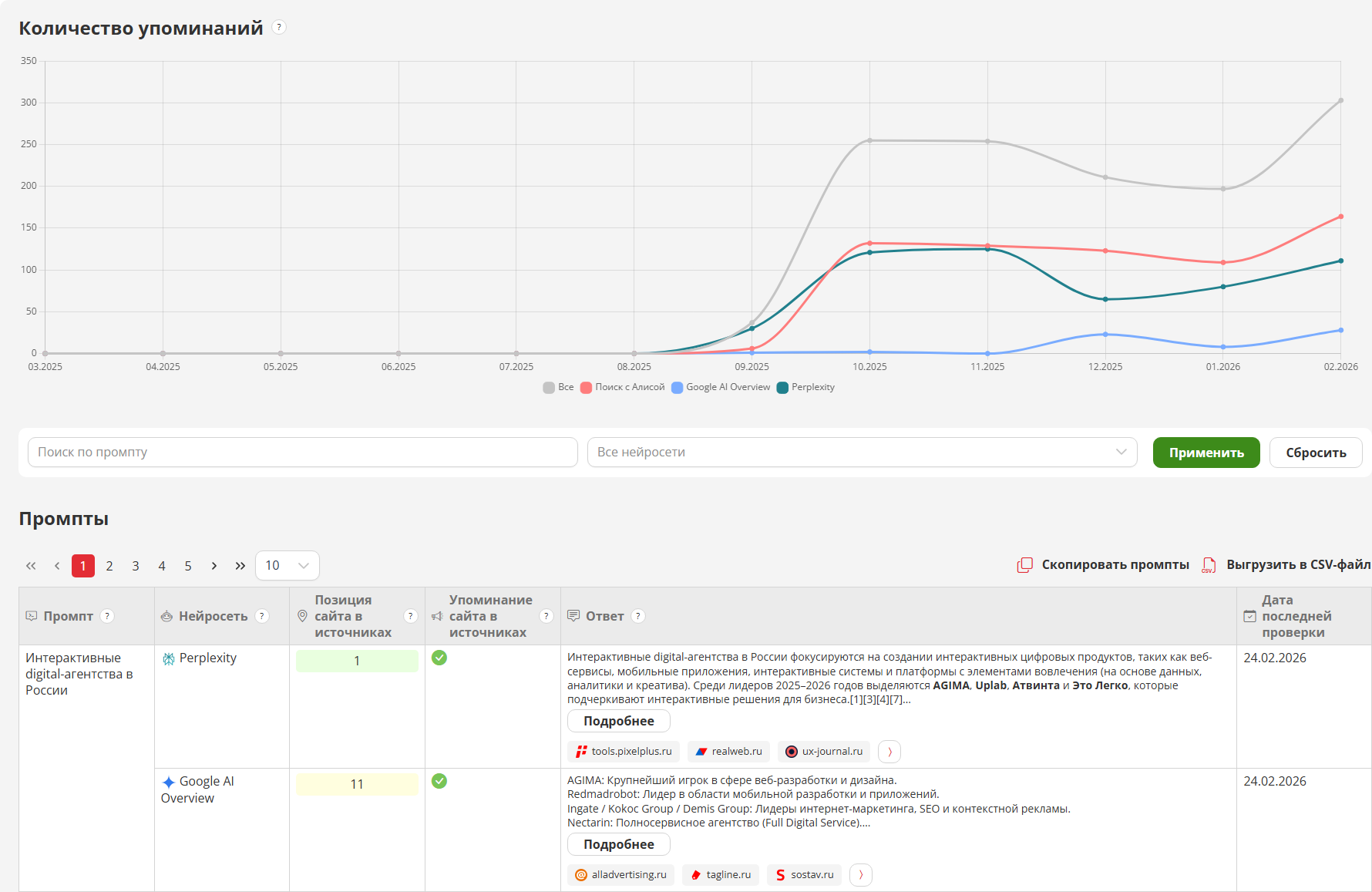

P.S. отслеживать динамику количества проиндексированных страниц в Яндексе и Google удобно в Модуле ведения проектов на вкладке «Аудит».

Читайте также

ТОП-4 популярных инструментов

Узнайте, как увеличить SEO‑трафик сайта в 3+ раза?

это займёт около 20-30 секунд