Проверка файла robots.txt

Robots.txt — файл в корне сайта, который содержит директивы для роботов поисковых систем: разрешает или запрещает индексировать страницы, записи, разделы. Если файл составлен с ошибками, возможны проблемы с индексацией и ранжированием.

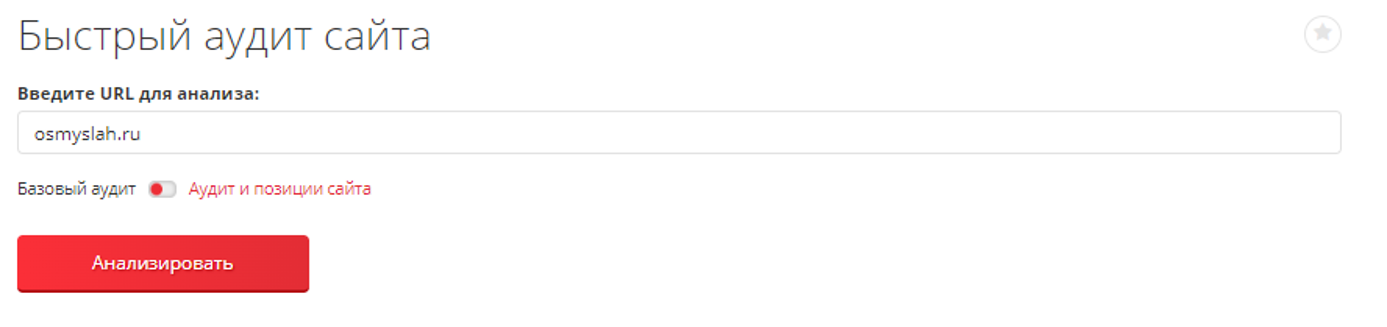

Наш комплексный сервис «Быстрый аудит сайта» проверяет корректность файла robots.txt и дает рекомендации.

Как проверить robots.txt?

Сервис работает в двух режимах — «Базовый аудит» и «Аудит и позиции сайта». Проверить robots.txt можно в любом из них. Введите домен, кликните «Анализировать».

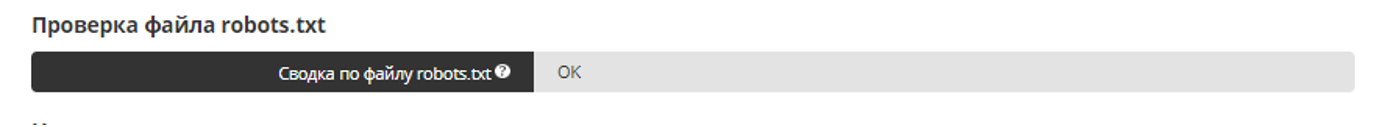

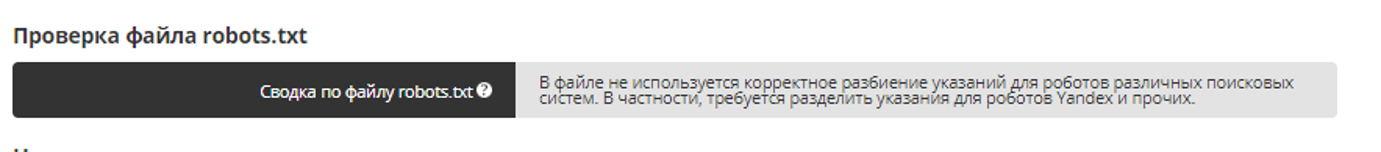

Результат готов через несколько минут. За проверки списываются лимиты: 1 домен — 25 лимитов, 1 запрос — +1 лимит.

Онлайн-инструмент анализирует сайт по 22 параметрам, в том числе проводит проверку robots.txt: проверяет наличие файла, его расположение, директивы.

Если robots.txt содержит ошибки, инструмент дает рекомендации.

Вопросы и ответы

Что должно быть в файле robots.txt?

Файл robots.txt содержит указания, которые разрешают или ограничивают поисковым роботам обход и индексирование категорий, документов, файлов. В robots.txt может находиться адрес Sitemap — XML карты сайта, но это не обязательное требование.

Что нужно закрывать в файле robots.txt?

В файле robots txt нужно закрывать дубли страниц, динамические, временные страницы, служебные разделы и документы.

Как правильно настроить файл robots.txt?

Директива User-agent указывает, к роботам какой поисковой системы относятся разрешения и ограничения. Директива Allow разрешает, директива Disallow запрещает индексирование. Директива Clean-param ограничивает доступ к динамическим страницам. Читайте по ссылке подробное руководство «Продвинутое использование robots.txt без ошибок».

Рейтинг статьи:

По оценкам 43 пользователей

Другие материалы