17 самых популярных задач технической оптимизации сайта — проблемы и решения

Сегодня мы постараемся разобрать 17 типовых, иногда холиварных вопросов, типа настройки индексации пагинации, устранения дублей, чистки индексов и так далее. Прежде чем говорить о технической оптимизации сайта, напомним, что техническое состояние и индексация — фундамент нашей пирамиды Маслоу в SEO.

Технические ошибки могут помешать сайту попасть в ТОП, в то же время их устранение никак не повысит релевантность страницы по конкретному пользовательскому поисковому запросу. Они лишь устраняют преграды, которые существуют у этого сайт на пути в ТОП-10. Переходим к проблемам в технической оптимизации и методам их решения.

1. Плохая индексация сайта

Ситуация звучит следующим образом: «Мой сайт плохо индексируется поисковыми системами, что делать?» Типичные кейсы этой ситуации:

-

новый сайт;

-

плохо индексирующиеся поддомены;

-

крупный проект, который не полностью индексируется.

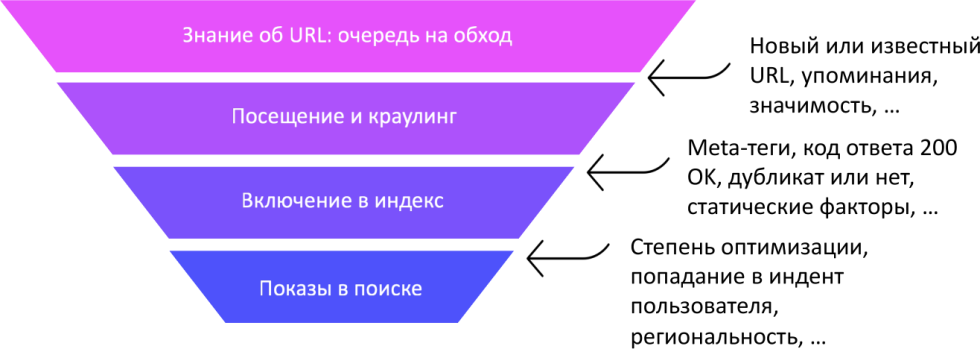

Как с этим жить и что с этим делать? Нужно понять причину плохой индексации, поскольку для поисковой системы это воронка.

Изначально вы должны добиться того, чтобы URL попал в очередь на вход, то есть информация, что такой URL вообще существует, появилась в базе краулера поисковой системы. После чего краулер должен «постучаться» в этот URL-адрес, чтобы узнать, что он представляет из себя. Дальнейшее продвижение будет зависеть от того, какие метатеги настроены на этой странице, какой у него код ответа, будет рассматриваться, дубликат он или нет, достаточное ли у него значение статических факторов. После этого определяется включение в индекс, и если вам повезет, произойдет показ этого URL в выдаче.

Все это необходимо знать, чтобы разобраться с проблемами индексации. Если у вас большой проект и он действительно плохо индексируется, то разобраться с проблемой быстро не получится. Надо понять, на каком из этапов мы застряли, проблема может быть на любом из них. Он может не включаться в индекс из-за:

-

недостаточного значения статистических факторов;

-

поисковая система может не знать о существовании такого URL-адреса;

-

возможно, у него неправильные настройки — запрет в robots, метатеги и т.д.

Откуда вообще поисковая система узнает о существовании страниц?

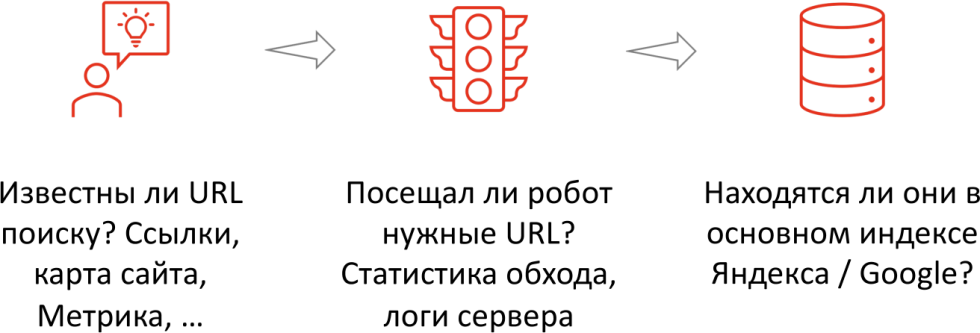

Она смотрит на ссылки внутри сайта, между сайтами, на карты сайта, оценивает Яндекс.Метрику, Яндекс.Элементы, Яндекс.Браузер и другую информацию, из которой она может получать сведения о том, что такой URL-адрес существует. Зачем это нужно поисковой системе? Во-первых, она не может брать и использовать данные из разных сервисов — у них, как правило, разные лицензионные соглашения, разные команды, то есть дележка данных остается таким деликатным моментом. Например, мы знаем, что Яндекс.Деньги не принадлежат Яндексу, а, скорее, Сбербанку. К примеру, использовать лежащие на вашем счету средства на ранжирование сайта, как минимум, не слишком корректно — требуется формальное разрешение. Это нужно для того, чтобы точно представлять — какие URL-адреса пользователи посещают, быстро включать в индекс те URL-адреса, на которых наблюдается значимый поисковый трафик. Дальше нужно понять, посещал ли робот данный URL, то есть смотреть статистику обхода и логи сервера, и только потом проверять, находятся ли они в основном индексе поисковой системы. Рассмотрим на примерах.

Кейс 1: URL были обойдены

Здесь нужно двигаться по шагам:

-

Используйте функцию «Переобход страниц» в Яндексе или «Проверка URL» в Google Search Console, в том числе с добавлением хабовых (разводящих) страниц, которые ссылаются на большое количество других URL-адресов.

-

Загрузка XML-карты на сервер с указанием пути к ней в панели Вебмастера (для больших сайтов можно использовать несколько карт).

-

Установка внутренних ссылок на нужные и/или новые URL-адреса. Здесь используется перелинковка, создание страниц-хабов, которые распределяют трафик, и «Ловец ботов».

-

Обход страниц по данным из Яндекс.Метрики. Это та самая история, когда вы можете использовать привлечение поискового робота на ваш сайт, чтобы он посещал URL-адреса, известные пользователям. Здесь достаточно нескольких пользователей, чтобы они просто прокликали по вашему сайту, просмотрели большое количество страниц — тогда робот с большой вероятностью отправится и индексировать. К опции следует отнестись с осторожностью, так как возможен обход «мусорных» URL, появление дублей. Мы подробно остановимся на вопросе, что делать, чтобы этих дублей не было. На самом деле, многие, кто делал обход по Яндекс.Метрике, получал множество «мусорных» страниц, возмущаясь тем, что ему «насоветовал» Яндекс.

-

Установка внешних ссылок на хабовые страницы, повышение статического веса URL;

-

Привлечение трафика, ссылок из социальных сетей, ссылок из новостей.

Это стандартный набор тех мер, которых достаточно, чтобы URL включались с индекс. Подробнее остановимся на таком понятии, как хабовые страницы.

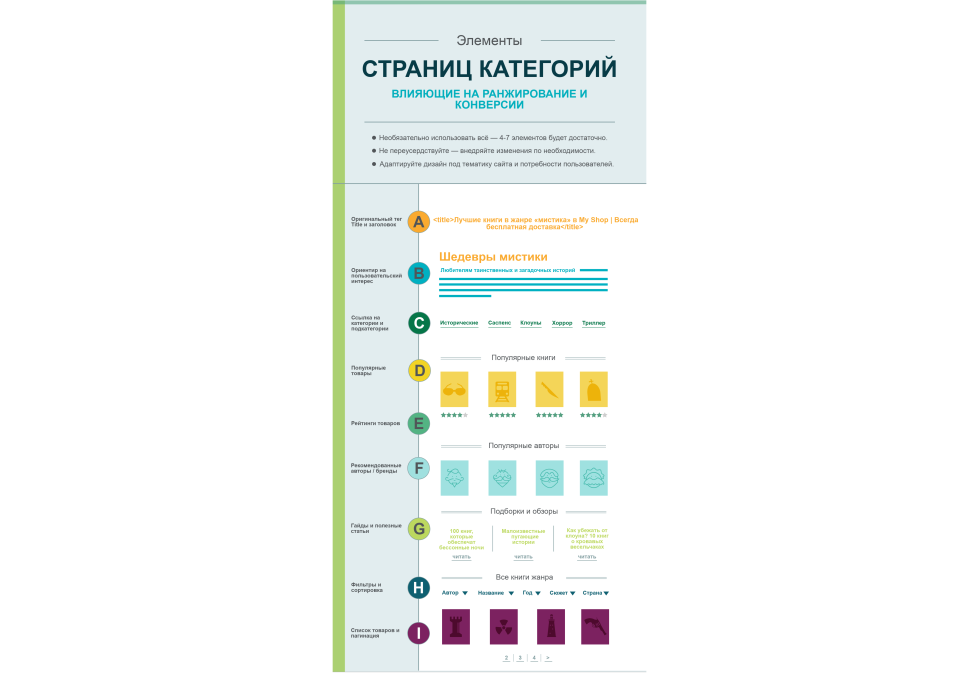

Что представляют собой хабовые страницы

Это так называемые «разводящие» страницы, которые содержат большое количество ссылок на другие страницы. К хабовым страницам можно отнести html-карту сайта — отдельная страница, которая содержит структуру вашего сайта со ссылками на все разделы, подразделы, детальные страницы и т.д.

Конечно, к таким страницам нужно относиться осторожно, так как они должны нести реальную пользу для пользователей, а не просто быть «складом» для сотни ссылок. Их нужно грамотно оформлять, плюс есть определенный порог (в районе 2500 ссылок на одной странице), после которого поисковая система будет менять стратегию поведения и перестанет включать страницы в индекс. Есть кейсы, когда страницы проиндексированы частично — например, всего 40% от общего числа ссылок.

Есть инструкция по созданию хабовых страниц, они должны:

-

содержать оригинальный заголовок;

-

быть ориентированы на пользователя;

-

иметь ссылки на категории, подкатегории, популярные товары, рекомендованные бренды, отзывы, рейтинги, руководства, гайды, демонстрации, сортировку, фильтры и т.д.

Эту концепцию активно пропагандирует Amazon, когда категории трансформировались в некоторые хабы, которые полностью удовлетворяют потребностям пользователя по неоднозначным запросам — имеется в виду запрос, подразумевающий возможность выбора. Например, «велосипед» — детский, женский, мужской, шоссейный, история изобретения велосипеда, насосы для велосипеда и т.д. То есть, это такие страницы, которые дают всеобъемлющий ответ на вопрос, с их помощью вы наверняка удовлетворите свой запрос.

Кейс 2: URL не были включены в индекс

Это абсолютно другая история. Чтобы понять, что страницы были обойдены, нужно выполнить такие действия:

-

Проверка ответа сервера, метатега robots, rel="canonical и других способов запрета на включение документа в индекс. Если страница была обойдена, вряд ли она была запрещена в robots, тогда бы поисковая система не стучалась, хотя Google все равно бы стучался, если на странице есть трафик.

-

Если запрещающих тегов нет, то нужно смотреть статус исключений и URL в панелях Вебмастера. Обычно, выводится некоторый статус: редирект, дубль, недостаточно качественная, неподдерживаемый формат, ошибка HTTP. Есть большое количество проектов, где в панели Вебмастера выводится сообщение, что страница исключена как недостаточно качественная, но при этом она присутствует непосредственно в индексе. Почти всегда база данных Яндекс.Вебмастера и основного робота, который работает с ранжированием, отличаются. Надо понимать, что сейчас это наиболее ярко заметно. Если в панели Вебмастера пишут, что документ исключен как недостаточно качественный, то вполне возможно, он присутствует в индексе. Здесь важно дополнительно проверять с помощью инструмента проверки на индексацию Пиксель Тулс.

-

Повышение уникальности одного URL относительно другого: новые блоки, рандомизация, шаблонные либо уникальные тексты и т.д.;

-

Оценка наличия спроса, который удовлетворяет URL и соответствует интенту пользователя. На самом деле, вы можете создать любую страницу, но если она не удовлетворяет потребностям, которые пользователи формируют в поиске, поиск не заинтересован содержать такую страницу, вам она тоже не нужна, так как она не будет привлекать поисковый трафик.

-

Работы по увеличению краулингового бюджета, улучшение статических факторов. Краулинговый бюджет — некоторый объем ресурсов, который поисковая система готова тратить на индексацию краулинга вашего сайта. Если ваш сайт большой, значимый, авторитетный, на него много ссылок, у него большая посещаемость, то поисковая система выделит достаточно много ресурсов, чтобы такой сайт индексировался.

Если сайт давно не обновлялся, он старый и никому не нужный, содержит низкое качество страниц, объем краулингового бюджета уменьшается. На него влияет появление новых материалов, PageRank-страниц, время загрузки кода, объем текста, уровень вложенности, количество ссылок.

Анализ с помощью Яндекс.Вебмастера

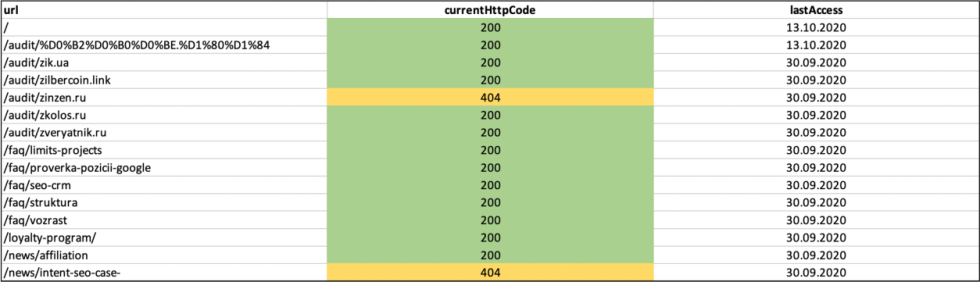

Чтобы выполнить анализ, нужно зайти в панель Яндекс.Вебмастера > Индексирование > Статистика обхода > Все страницы > Скачать XLS-файл с 50000+ строк.

Вы сможете понять, была ли обойдена страница, когда она была посещена, какой код ответа увидела поисковая система и т.д. По сути, это та информация, которой владеет поисковая система. Как правило, этого более чем достаточно, чтобы ответить на вопросы: «Посещалась ли страница роботом? Если да, то когда?» и «Почему она не была включена?». В Google Search Console за это отвечает раздел «Покрытие». Вы можете просто с помощью анализа логов посмотреть, что посещалось, когда и т.д.

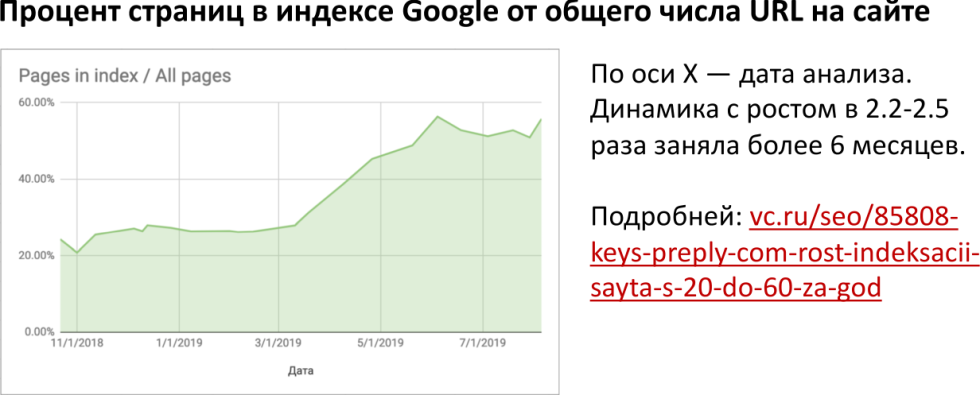

Кейс 3: Рост индексации в 2,5 раза

В опубликованном кейсе ребята рассказали о том, каким образом с помощью перелинковки увеличить полноту индексации примерно в 2,5 раза.

Да, этот кейс занял 6-8 месяцев. По сути, они прокачивали статические факторы URL за счет перелинковки, то есть, грубо говоря, увеличили количество входящих ссылок на те страницы, которые были важны в индексе. Более подробно о кейсе можно прочитать по ссылке.

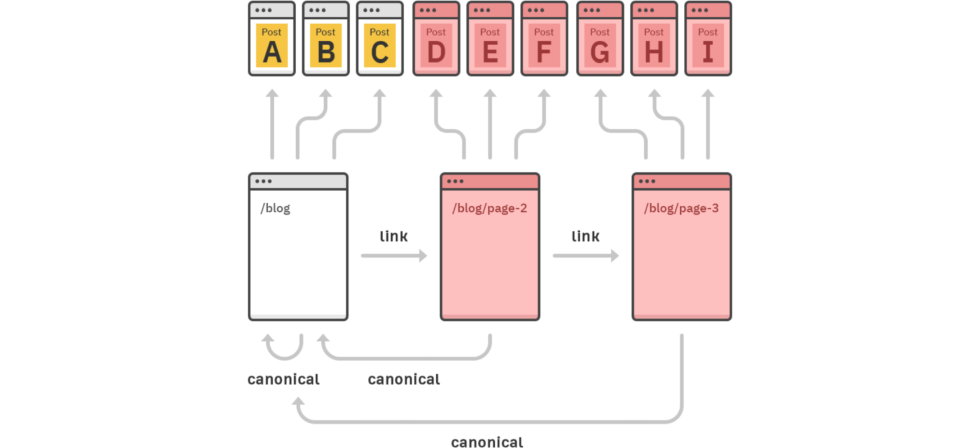

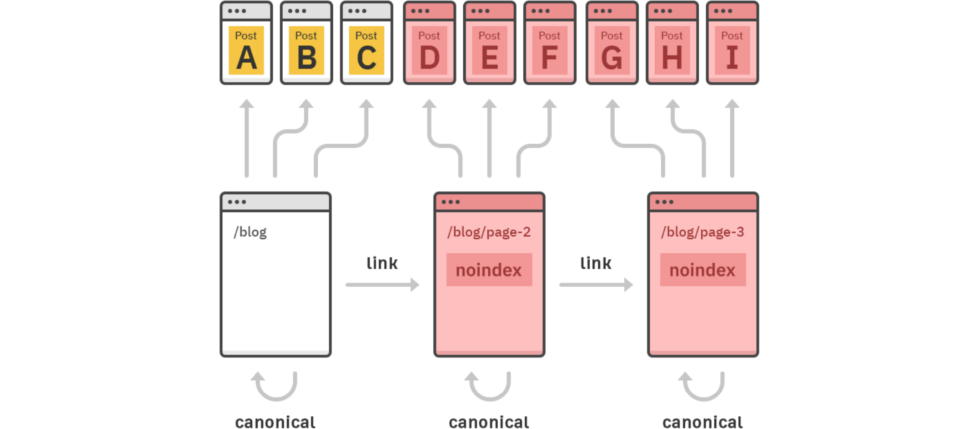

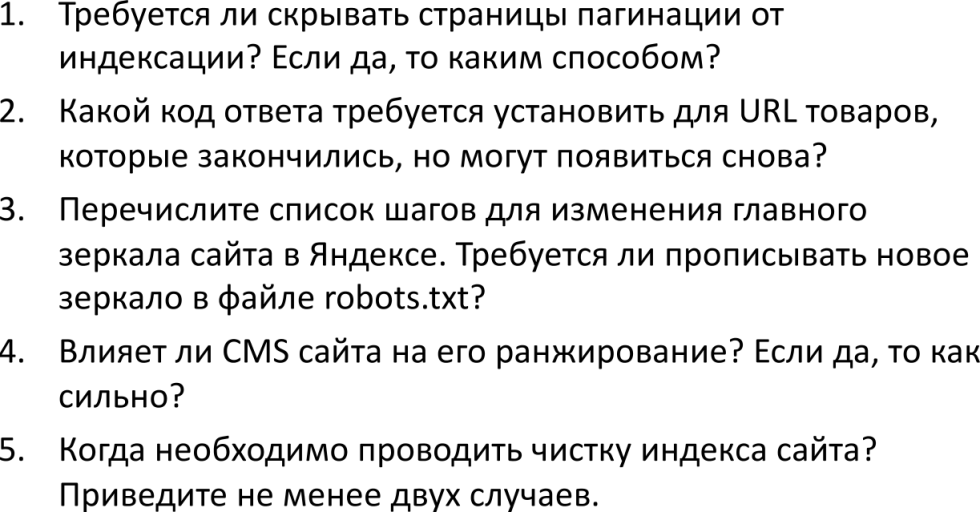

2. Настройка пагинации

На сайте есть каталог или какой-то раздел, на котором есть постраничная навигация — «пагинация». Нужно ли ее закрывать от индексации? Есть четыре основных момента, которые нужно четко понимать и выполнять:

-

Страницы пагинации должны быть доступны для индексации, для улучшения индексации карточек товаров при перелинковке, распределении статического веса внутри сайта. То есть фактически мы понимаем, что эти страницы нужны для пользователя, и если они будут закрыты для индексации, поисковая система будет «напрягаться», поскольку пользователи посещают страницы, а поисковая система не может понять, куда они идут. Второй момент, который мы привлекаем, если закрываем страницы пагинации от индексации — карточки товаров, на которые часто можно попасть только с помощью постраничной навигации. Частая ситуация, особенно, в случае плохо настроенной перелинковки — например, мы должны перейти на определенную страницу, а потом кликнуть на какой-то товар, чтобы дать поисковой системе возможность узнать, что страница в принципе существует.

-

Данные документы способны привлекать дополнительный поисковый трафик по низкочастотным запросам, если их адаптировать. В ряде случаев, если вы посмотрите, привлекает ли на текущий момент страница пагинации трафик в Яндекс.Метрике, вы обнаружите положительный ответ. Конечно, этот объем редко превышает 1% от общего поискового трафика. Если вы проведете дополнительные работы по увеличению этого трафика, вы получите еще больший трафик, об этом мы расскажем более подробно.

-

Конечно, чтобы это произошло, нужно уникализировать все страницы по тегу Title и метатеги, независимо от их природы.

-

Атрибуты rel="next" rel="prev" перестали поддерживаться Google. То есть раньше можно было разметить, то есть сказать, что это первая, вторая страница, сегодня поисковая система достаточно хорошо с этим самостоятельно справляется. Более того, у Google есть такой инструмент, как параметр URL в Google Search Console — вы можете указать для любой переменной, каким свойством она обладает, что она разделяет на странице.

Разберем основные типичные ошибки в настройке пагинации:

-

Установка rel="canonical" со всех страниц на первую. Страницы просто не будут включены, к тому же они не являются каноничными — то есть не являются копиями, ввиду проведенных работ по уникализации.

-

скрытие с помощью nofollow-ссылок, метатегов, robots.txt

Поделимся чуть более продвинутыми советами, если на сайте есть постраничная навигация. Как максимализировать поисковый трафик на страницы пагинации и увеличить эффект от них:

Вы должны иметь не две ссылочки, допустим на вторую и третью, а желательно побольше ссылок на страницы пагинации, чтобы уровень вложенности карточек был меньше. Будет полезной ссылка на «Все товары», чтобы пользователь мог в первый клик перейти в категорию, во второй — увидеть все карточки и в третий — попасть на детальную карточку. Нужно убрать текст с постраничной навигации, чтобы он не дублировался с первой, не забывайте уникализировать страницу под свои НЧ. Иногда имеет смысл посмотреть, какие товары могут потенциально выводиться или каким-то образом настроить автоматизацию, чтобы часть слов из карточек товаров использовать в Title. Такие способы есть, они достаточно эффективны, зачастую приводят к объему трафика на странице пагинации на уровне нескольких процентов.

3. Устранение дублей

1С-Битрикс, Joomla, WordPress, другая CMS генерирует технические дубли страниц с GET-параметрами, что делать? Приведем несколько фактов:

Например, вы хотите завести рекламную кампанию и прописать utm-метку. Логично, что такая страница должна отдаваться поисковой системой, потому что вы просто прописали utm-метку. С точки зрения поиска, это дубль, потому что utm-метка, приписанная к URL-адресу — это некоторый другой URL-адрес, его содержимое полностью совпадает с содержимым исходной страницы. Дело не в CMS, хотя некоторые CMS немного больше этим грешат. Остановимся более подробно на профилактических мерах.

Устранение причин дублей

Необходимо бороться с причинами появления дублей, так, как поступает грамотный врач в вопросе лечения своих пациентов. Оптимальный список мер для решения проблем дублей:

-

Внедрение атрибута rel="canonical" тега link на всех страницах сайта. Тем самым мы запретим к индексации большое количество дублей с помощью атрибута для страниц:

-

указания числа товаров на странице («&show=60»);

-

сортировок («&sort=name»), если нет подходящего спроса;

-

фильтраций уровня 4 и более.

-

-

Внедрение ЧПУ для всех страниц сайта, в том числе и для «умного» фильтра уровня 1-3 (в зависимости от товарной матрицы и спроса).

-

Скрытие всех страниц с GET-параметрами от индексации с помощью файла robots.txt. Правило: «Disallow: *?*». По необходимости: открытие нужных параметров с помощью правила «Allow: *?нужная-переменная*». Если вы понимаете, какие GET-параметры у вас запрещены, а какие разрешены, вы избавляетесь от очень большого количества дублей.

Про сортировки — почему не всегда есть смысл их скрывать тот индексации или склеивать с помощью атрибута rel="canonical". В случае с недвижимостью, сортировка по возрастанию цены может привлекать очень много трафика под запросы, оптимизированные под какие-нибудь «квартиры недорого». Сортировка по убыванию цены, где наверху находятся самые дорогие квартиры, может привлекать трафик по запросу «купить элитную квартиру», «купить дорогую квартиру» и т.д. Такой спрос существует, это имеет смысл оптимизировать, а не закрывать.

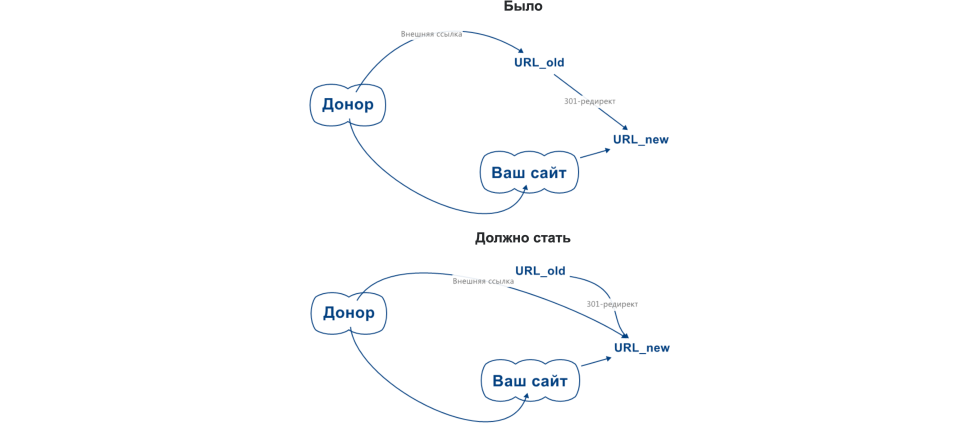

А когда дубли уже есть?

Если при сканировании были обнаружены дубли, вам требуется сделать две простые вещи:

Настройте 301-код ответа для всех дублей на канонические URL, которые наиболее близки к тому, что мы хотим. За исключением тех случаев, когда мы обнаружим, что страницу можно оптимизировать с помощью сортировки «дорого-дешево», как в случае с недвижимостью. Иногда бывает так, что дубли генерируются просто пользователем, который неправильно набрал URL-адрес, или поиск перебрал некоторые GET-параметры в URL, такое тоже бывает. Бывает так, что поисковый робот в строку поиска на сайте ввел какой-то запрос, шел не страницу поиска посмотреть, что там происходит, то есть робот сам сделал дубль. Также нужно удалить ссылки на данные URL внутри сайта, настроенный 301-редирет позволит сохранить все факторы.

4. Важна ли скорость загрузки

Вопрос звучит следующим образом: «Проверяю скорость с помощью Google PageSpeed Insights, требуется ли добиваться показателя в 100 баллов?», «У моего конкурента 5 баллов, почему он в ТОПЕ?».

1. На самом деле, показатели Google PageSpeed Insights и показатели других сервисов не учитываются в ранжировании URL-адреса, это нужно понимать. Если мы смотрим какую-то страницу и она имеет показатель оптимизации 5, а другая страница имеет 100 — это не значит, что она будет лучше или хуже ранжироваться, это не значит вообще ничего. Учитываются только реальные показатели касательно поведенческих факторов и некоторых метрик.

2. Как следствие, работы по увеличению балла Google PageSpeed Insights не ведут к прямому росту позиций и трафика документов. Многие тратят на это массу времени, оптимизировали загрузку и удивляются тому, что позиции не растут.

3. Скорость загрузки косвенно влияет на поведенческие факторы и конверсию, что в свою очередь, учитывается поисковыми системами. Если реальные пользователи почувствуют улучшение, их поведение изменится в лучшую сторону, тогда поисковая система учтет вашу работу постфактум довольно длительно, учитывая то, что внутрисайтовые поведенческие метрики менее значимы, чем кликовые поведенческие факторы, это положительно скажется на ранжировании.

4. Релевантность URL-адреса по запросу будет всегда давать существенно больший вклад в ранжирование, чем технические показатели.

5. Ориентируйтесь на пирамиду технических метрик: Индексация > Дубли и спамность > Адаптивная версия > Скорость работы > Код.

То есть добиваться показателя в 100 баллов не требуется до тех пор, пока у вас нет других проблем с релевантностью данного URL-адреса по поисковым запросам.

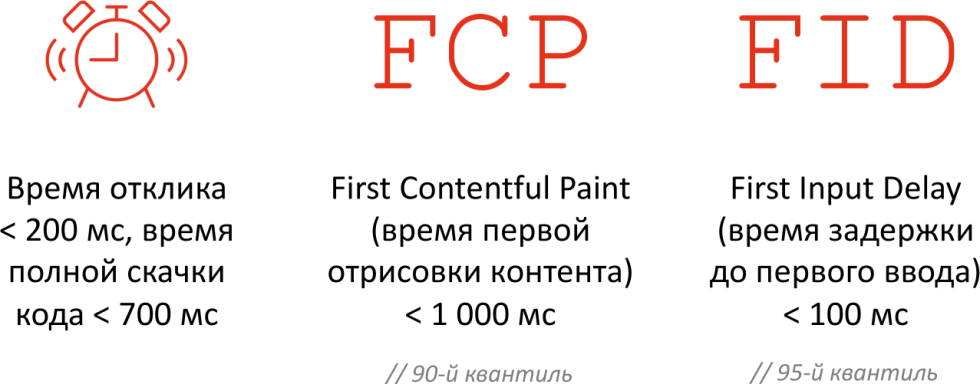

Целевые показатели скорости

Есть всего три показателя, на которые стоит ориентироваться:

Время отклика должно быть не более 200 мс, время полной скачки кода — менее 700 мс. И два параметра, за которые активно топит Google, которые по нашему мнению не сказываются напрямую на ранжировании: время первой отрисовки контента (страница должна отрисоваться за 1 секунду) и время задержки до первого ввода, когда пользователь начинает взаимодействовать с вашим сайтом и на его действие срабатывает отклик (показатель не должен превышать 100 мс).

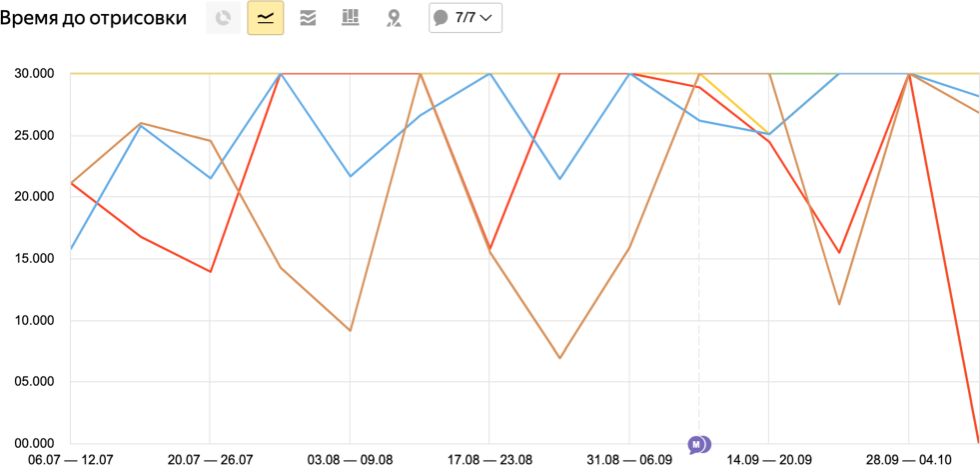

Анализ на реальной практике

Мы призываем анализировать данные загрузки на реальной статистике — для этого можно использовать Яндекс.Метрику > Отчеты > Мониторинг > Время загрузки страниц.

Анализ и настройки:

-

настраивают 90% квантиль;

-

страницы, по которым достаточно много просмотров (более 100), так вы сможете увидеть страницы, на которых есть реальные проблемы со временем отрисовки;

-

сортировка по убыванию параметра «Время до отрисовки» — начинайте с максимума (30 секунд), именно с этих страниц нужно начинать оптимизацию;

-

мы должны оценивать «Время ответа сервера» по 50% квантилю.

Скорость загрузки продолжает оставаться важнейшим параметром для всех поисковых систем, поэтому с этим показателем нужно работать и совершенствовать его.

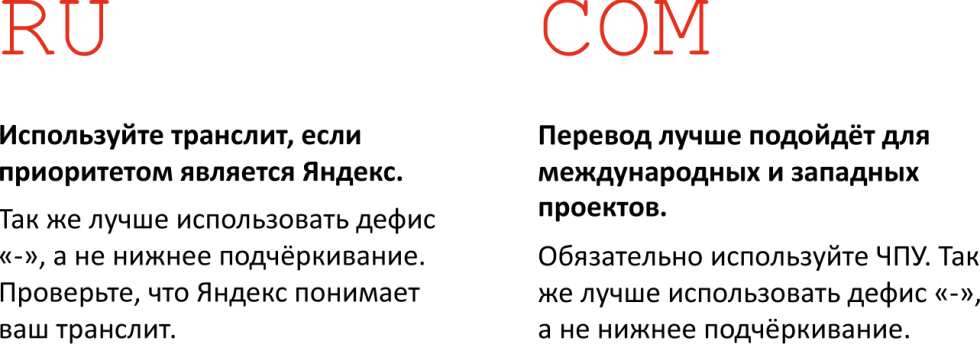

5. Транслит в URL или перевод?

Что лучше для продвижения — транслит в URL или перевод? Ответ на этот вопрос зависит от того, под что вы продвигаете.

Для ру-сегмента, в частности для Яндекса, в приоритете транслит, потому что у Яндекса есть определенное количество факторов, которое учитывает трехбуквенное совпадение URL-адреса с поисковым запросом с учетом транслитизации, грубо говоря, и домена тоже. Если в домене есть три буквы подряд, которые содержатся в поисковом запросе, то вы получите небольшой «плюсик, то же самое касается и URL-адреса. При этом рекомендуется использовать дефис «-», а не нижнее подчеркивание «_» для разделения различных слов. В Google лучше применить перевод, в то же время обязательно использовать ЧПУ, с точки зрения оформления, рекомендации относительно использования дефиса «-» также остаются актуальными.

6. Поисковые запросы и JavaScript

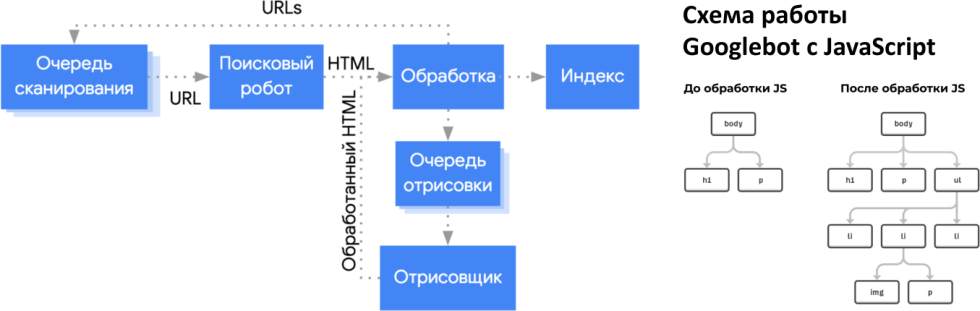

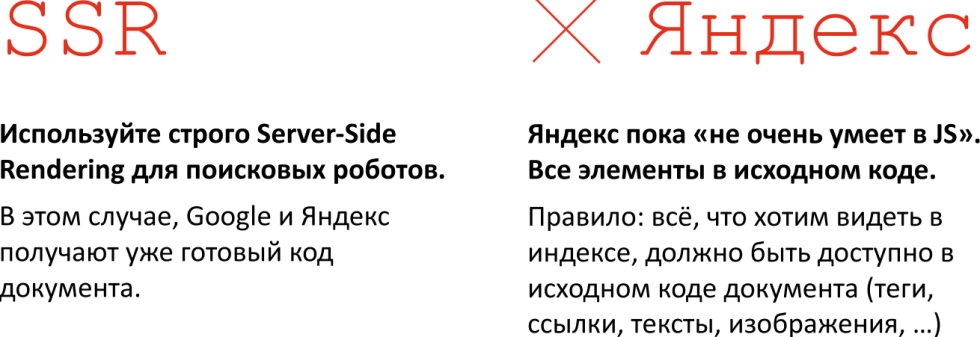

Вопрос звучит так: «Современные поисковые системы уже давно понимают JavaScript (JS), на этот счет можно не париться, правда?» Это очень частое заблуждение, на текущий момент с JS достаточно хорошо ладит Google, но индексация в этом случае происходит в несколько уровней.

Сначала робот смотрит тот HTML, который видит, обрабатывает его и включает в индекс. И только потом отдельной веткой ваш JavaScript-код адресуется в некоторую очередь на отрисовку, отрисовывается, и обработанный HTML включается в индекс. До обработки JavaScript поисковая система может увидеть Н1, Р, а после обработки — кучу контента, который содержится на странице. Если вы будете рассчитывать на рендеринг со стороны Google — у вас будет достаточно низкая полнота индексации и большое количество контента, содержащееся в JavaScript, все равно не будет включаться. Есть статистические исследования, на основании которых можно убедиться, что даже у очень крупных сайтов процент индексации от JavaScript-контента не превышает 20-30%.

JavaScript и SEO — что происходит на практике?

На самом деле, на практике все просто. Нужно использовать Server-Side Rendering для поисковых роботов. Если вы видите, что на ваш сайт зашел поисковый робот, то вы контент ему отдаете после того, как он отрендерился (выполнил JS) на вашем сервере. В случае с Google это жизненно необходимо, в лучшем случае, около 20-30% документов могут быть нормально проиндексированы, если пренебречь этим правилом, а в случае в Яндекс — 100% будут проиндексированы неправильно.

Нужно, чтобы все элементы, которые вы хотите видеть в индексе, содержались в исходном коде — теги, ссылки, изображения и т.д.

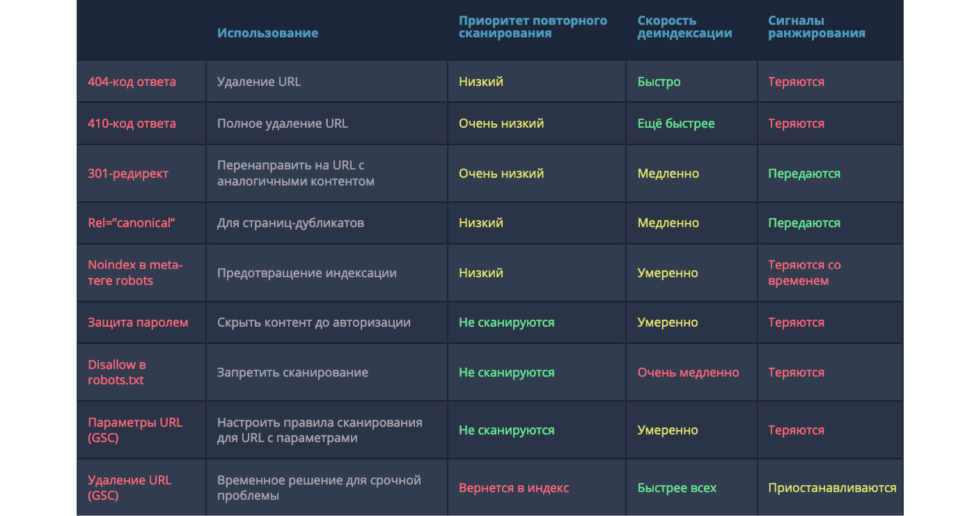

7. Запрет на индексацию

Здесь частый вопрос звучит так: «В индексе много мусора. Как лучше скрывать URL от индексации? Использовать robots.txt, noindex, canonical?» Ответ зависит от решения задач, но лучше использовать 301-редирект на близкие по смыслу URL-адреса — это принесет определенный профит:

-

те пользователи, которые перейдут по этим «мусорным» страницам, смогут попасть на нужную страницу или хотя бы близкую по смыслу;

-

сохранятся ссылки, которые ведут на эти «мусорные» страницы.

Если вы хотите добиться полного удаления трафика на эти URL-адреса, настраивайте 410-код ответа, это полное удаление.

Памятка по методам деиндексации (всего существует 9 методов удаления страницы из индекса поисковой системы) доступна по ссылочке.

О том, как находить эти «мусорные» страницы, мы подробно говорили в одном из предыдущих вебинаров Пиксель Тулс. Смысл в том, что вы должны просканировать ваш сайт какой-то поисковой системой. Вы можете задать в поисковую систему такой оператор, как «site: доменное имя», и просто посмотреть, какие страницы он нашел. Если у вас не очень большой сайт, все страницы, которые включены у него в индексе, вы найдете. Третий способ, который вы можете использовать — зайти в панель Вебмастера или Google, посмотреть все страницы, которые были посещены поисковым роботом, скачать их, посмотреть на URL-адреса. В ряде случаев по определенным признакам — например, добавление какого-то параметра, например, «/велосипеды /?» и какой-нибудь GET-параметр, типа Р=10900&sort=price — то есть какая-то страница, которая не несет ценности для пользователя.

8. Скрытие части контента

Можно ли скрывать для удобства пользователей часть контента на странице, скажем, текст или Н1? То есть, мы предполагаем, что пользователю будет удобнее, если мы скроем часть содержимого. О чем нужно помнить:

-

у поисковых систем есть санкции за скрытый текст и клоакинг (когда посетителю сайта показывается одно содержимое страницы, а роботам поисковых систем — другое);

-

если скрытие обусловлено реальным удобством для пользователей, то нужно подумать — нужен ли этот текст или элемент на странице (может, стоит от него отказаться вовсе?);

-

скрытый текст или ссылки получают меньший «вес» при ранжировании — если мы размещаем текст «под катом», то данные вхождения будут менее приоритетны для поисковой системы;

-

после того, как вы выполнили определенные работы, обязательно посмотрите, как это видит робот.

Это оправдано на адаптивных версиях сайтов, поскольку часто на мобильных версиях скрывается меню и т.д. Если мы говорим о Google, то элементы, которые скрыты в основном коде, будут получать меньший приоритет.

9. Валидность исходного кода

«Разработчики сделали сайт, я проверил код и он оказался невалидным по проверке W3C. Надо ли требовать деньги обратно?»

Что нужно делать:

Валидность HTML-кода не имеет значения для ранжирования и для пользователей. Как правило, есть масса других более существенных проблем, требующих неотложного решения. Важно изучить то, как поисковые системы видят ваши поисковые страницы — то есть сохраненные копии и проверка URL-адресов.

10. Какую CMS лучше выбрать?

Это один из наиболее часто встречающихся вопросов, который задают пользователи, создающие сайты. Многие думают, что выбрав ту или иную CMS удастся избежать ряда проблем — может, поисковая система относится к какой-то CMS лучше, чем к другим, и стоит выбрать ее. Спешим развеять ваши сомнения и терзания — у поисковых систем нет каких-либо явных предпочтений к сайтам на той или иной системе управления. Говоря простым языком, CMS не является фактором ранжирования. Например, если сайт на Битриксе, поисковая система не может сказать «давайте его ранжировать выше или ниже», такого нет. Вопрос выбора CMS лежит в двух плоскостях — технической и финансовой, и вот на что нужно ориентироваться:

-

безопасность;

-

поддержка, развитие функционала;

-

один из самых важных технических моментов — наличие и достаточность на рынке команд, разработчиков и специалистов по разработке, которые могут полноценно работать с проектом на этой CMS;

-

стоимость внесения изменений и доработок.

На нашем опыте, хорошо себя зарекомендовали с точки зрения ранжирования и удовлетворения всех вышеобозначенных критериев 1С-Битрикс и WordPress. Подумайте трижды, прежде чем использовать конструктор типа Wix или uCoz — решение будет оправдано, только если это ваш первый сайт, и вы хотите попробовать себя в ВЕБе — в таком случае конструктор будет идеальным решением, позволяющим понять, за что вы платите деньги и чем занимаются ребята-разработчики. Частая проблема — пользователь заказывает сайт, но не до конца понимает, что хочет. Конструктор позволяет самостоятельно прощупать среду и окончательно определиться с целью.

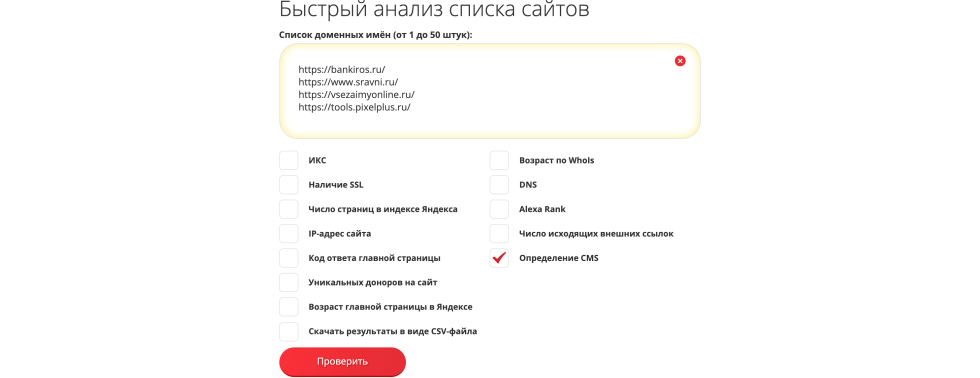

Полезные ссылки: CMS

Даем полезные ссылки, которые вам пригодятся:

1. Исследование: CMS и типовые показатели скорости загрузки - https://tools.pixelplus.ru/news/page-speed-research.

Здесь взято большое количество CMS — ребята прошлись по ним, посмотрели показали PageSpeed и оценили их работу.

2. Проверка CMS и показателей у списка сайтов — https://tools.pixelplus.ru/tools/analiz-saitov.

Вы можете посмотреть с помощью инструмента Пиксель Тулс, на каких CMS выполнены другие сайты, посмотреть возраст и т.д.

3. Переезд на новую CMS — https://pixelplus.ru/samostoyatelno/otvety-na-voprosy/indeksatsiya/296359.html.

Если вы после прочтения статьи задумаетесь о переезде на новую CMS, вам будет полезна изложенная в статье информация.

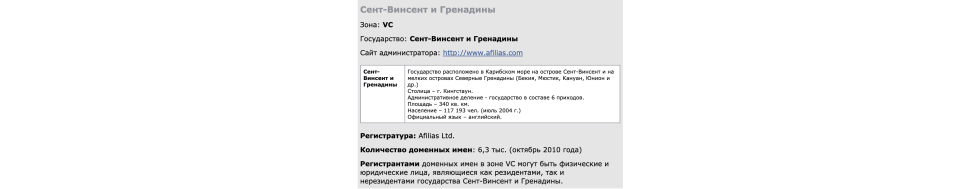

11. Роль доменной зоны

Вопрос звучит так: «Есть ли влияние доменной зоны на ранжирование?» или «Можно ли смело выбирать различные экзотические доменные имена?». Доменная зона является фактором ранжирования поисковой системы, в отличие от CMS. То есть, учитывается доменная зона.ru, доменная зона.com и так далее. При этом в .ru-выдаче более 80% ru-доменов, а в Google — еще больше.

Google еще более придирчив, чтобы сайт был выполнен на ru-домене, эта доля не уменьшается с течением времени (есть стабильная величина — 80-84%). Если мы опускаемся вниз по выдаче, то будем видеть все больше доменных имен не ru. То есть существует корреляция между доменной зоной ru и попаданием сайта в ТОП, в этом можно убедиться на странице Хопометров Яндекс и Google, которые присутствуют на Пиксель Тулс. Общий совет такой — сделать выбор в сторону национального домена второго уровня.

То есть того домена, который соответствует стране, в которой вы будете продвигаться. На скрине представлена доменная зона vc — Сент-Винсент и Гренадины. У нас был кейс, когда мы продвигали короткий красивый домен, вроде «двери.vc», а Google привязал его к островам Сент-Винсент, и мы не смогли нормально обеспечить ранжирование. В итоге пришлось менять домен.

12. Смена домена

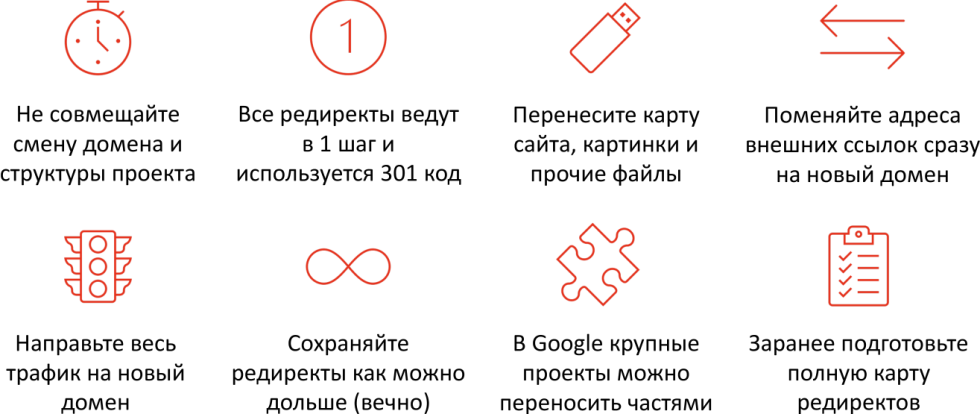

Как правильно переехать на другой домен? Можно ли сохранить позиции в Яндексе и Google? Смена доменного имени — достаточно штатная задача для SEO-специалиста, возможно полное сохранение позиций трафика при переезде (как минимум, можно сохранить 90% трафика). Важно придерживаться простого плана:

-

разместить по двум адресам полные копии сайта, желательно с относительными гиперссылками, чтобы ссылки внутри сайта вели относительно домена;

-

подтвердите оба сайта в панелях Вебмастера и Google;

-

настройте постраничный 301-редирект со старого домена на новый;

-

сообщите поисковой системе о смене главного зеркала индекса.

В Яндекс.Вебмастере это делается с помощью инструмента «Переезд сайта» в разделе «Индексирование». В Google есть инструмент «Изменение адреса», он рекомендует его использовать, если у вас меняется домен, но не меняется http, https. В случае с Яндексом рекомендуется использовать инструмент в любой категории, плюс-минус на текущий момент все проходит штатно. Но все же есть некоторые нюансы, которые нужно учесть при смене домена.

Важные нюансы при смене домена

В определенных случаях при смене домена возможны «накладки»:

Не нужно совмещать смену домена и структуру проекта — сначала раскатить сайт на старом домене, лишь потом переезжать. Не забывайте, что в Google можно переносить большие проекты частями.

Частый вопрос: «Достаточно ли доменного редиректа?» Его будет достаточно, если меняется только доменное имя, доменный редирект в этом случае будет отрабатывать для всех вложенных страниц, а для поисковой системы это будет выглядеть как постраничный редирект. Если при этом у вас что-то меняется, то нужно будет прописывать постраничный редирект.

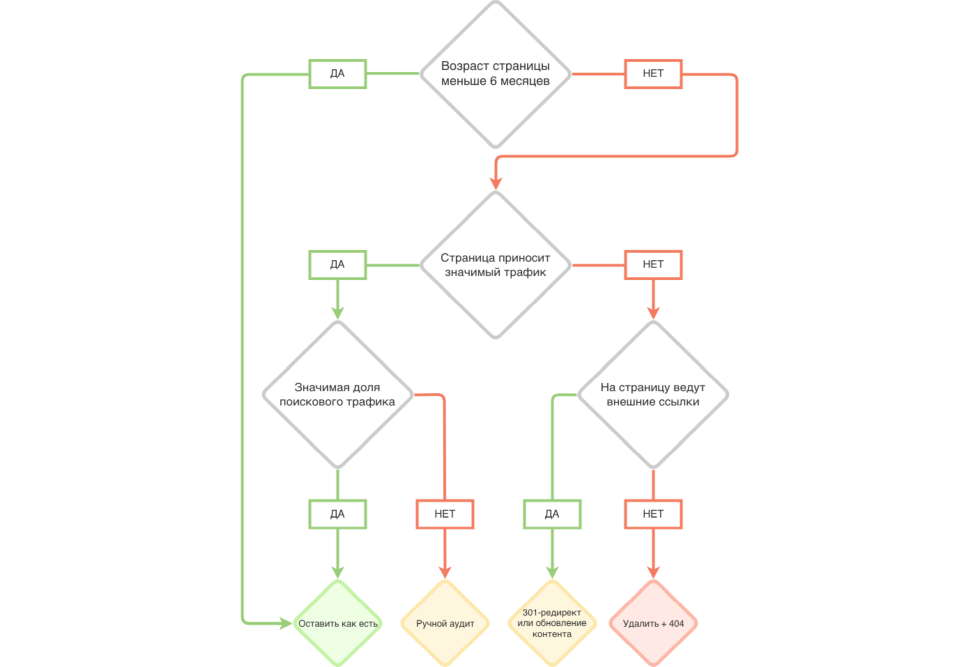

13. Чистка индекса

Как лучше поступить со страницами, трафик на которых равен нулю? Удалять ли эти страницы из индекса? На самом деле чистка индекса важна при наличии проблем в индексации или ранжировании. То есть, если у вас сложности с индексацией, домен не полностью проиндексирован или плохо ранжируется, имеет смысл задуматься о чистке. Не нужно делать чистку индекса просто «для галочки».

Чистка индекса актуальна для контентных проектов, где происходит «каннибализация» поискового трафика, то есть много статей, посвященных одному и тому же, или крупных проектов с большим количеством листингов, логических дублей и так далее.

Блок-схема чистки

Подробности и кейс вы можете изучить по этой ссылке, а прочитать о том, как разводить технические дубли можно здесь. Почему это работает?

В результате чистки индекса происходит улучшение хостовых факторов, в частности:

-

каждый URL становится немного качественней — то есть растет среднее количество взаимодействий пользователя в рамках URL-адресов;

-

увеличивается среднее время нахождения пользователей на всех URL, потому что, удаляя мусорную страницу, каждая оставшаяся качественная страница ведет к улучшению среднего показателя.

Логическая цепочка достаточно проста: чем меньше низкокачественных страниц, тем выше хостовые метрики и лучше ранжирование. Есть определенный кейс на эту тему, но если у вас все нормально с индексацией и с ранжированием, то по нашему опыту это не дает вау-эффекта, поэтому нет смысла делать для всех сайтов подряд.

14. Первая индексация сайта

Мы создали новый сайт и хотим отдать его на индексацию –то есть это первая индексация и первое знакомство с поиском. Здесь, как и в коммуникации с людьми, многое зависит от первого впечатления. Что нужно делать:

-

Открывать только полностью готовый сайт без единого раздела «в разработке»! Если это невозможно, то необходимо скрыть ссылки на все недоработанные разделы в меню.

-

Обязательно настройте страницу 404-ошибки и 301-редиректа на главное зеркало, это особенно важно для нового сайта. В любом случае поисковая система не знает, каким будет основное зеркало — версия с «W» или без «W», с «/» на конце или без него, и может начать индексировать все подряд, не понимая, что это зеркала.

-

Для ускорения используйте XML-карту сайта и обход по счетчикам.

15. Когда нужно внедрять canonical?

На большинстве сайтов не настроен атрибут rel=« canonical» тега link, требуется ли вообще его указывать и настраивать? На самом деле внедрение canonical для всех страниц позволяет избавиться от появления большой части дублей, которые генерируют сами пользователи, рекламные кампании, CMS и поисковые системы. Причем, чем больше сайт, тем большее количество дублей на нем будет. Несмотря на то, что настройка требует времени разработки, рекомендуется настраивать rel=« canonical» для всех проектов –особенно, для крупных.

16. Региональные поддомены

Создал региональные поддомены, но они плохо индексируются в Google/Яндекс, что делать? Ответ на этот вопрос зависит от поисковой системы. Мы постарались дать максимально полный ответ для двух поисковых систем.

-

в Яндексе очень важна региональная привязка этого поддомена в Яндекс.Вебмастере;

-

отличие региональной версии (шаблона) от «главного» сайта;

-

максимум региональной информации: отзывы, ассортимент, цены, нюансы доставки, информация о филиалах, сотрудниках и т.д. — все это будет сказываться положительно на ранжировании и индексации.

Мы подробно разобрали работу с региональными факторами ранжирования и вообще работу с региональным продвижением в Яндексе в одном из обучающих видео по ссылке.

В Google региональные поддомены редко являются выигрышной методикой для увеличения охвата. Постарайтесь сделать акцент на региональные папки и отдельные региональные страницы. Это значит, что существует отдельная страница, которая посвящена какому-то городу в какой-то тематике. Кстати, в Google сейчас довольно хорошо работаю региональные страницы.

Что еще важно:

-

Наличие ссылок на поддомен, если вы все-таки решили создавать поддомены с сайтов из того же региона. Есть кейсы, когда более-менее нормально ранжируются поддомены, если они представляют самостоятельную ценность. Это не сотни, а несколько поддоменов, на них есть нормальные региональные ссылки. Это важно, потому как Google очень внимательно при региональной привязке смотрит на привязанность ссылок с сайтами из одного и того же региона.

-

Важна геопривязка по домену с помощью «Google Мой Бизнес».

На нем обычно заканчивается все обсуждение, потому как подтвердить адрес «Google Мой Бизнес» для регионального поддомена мы не можем, в отличие от Яндекс.Вебмастера.

17. Товары, которых нет в наличии

Вопрос, например, звучит так: «У меня меняется ассортимент: часть товаров пропадает, потом снова появляется. Как лучше настроить работу для поисковой оптимизации?» То есть товара нет в наличии, он каким-то образом появляется, потом снова исчезает — мы не можем управлять этим процессом до конца, так как не можем достоверно знать, когда продукция появится и появится ли вообще. Есть пять шагов, которые требуется реализовывать, чтобы поисковая система была более корректной, а вы привлекали больше трафика:

-

Оставьте товары или объявления доступными для просмотра по прямой ссылке с кодом ответа 200 ОК. То есть, как только товар появится, у вас сохранится URL-адрес, просто он станет выводиться и в листинге.

-

На карточке нужно указать его статус — а именно то, что его нет в наличии. Укажите ссылки на близкие товары-аналоги, чтобы посетитель обратил на них внимание. Добавьте планируемую дату поступления, добавьте возможность совершить предзаказ этого товара с помощью отдельной формы.

-

Скройте ссылки на товары/объявления из листинга — оставить их можно в XML- и HTML-картах сайта. Чтобы пользователи из листинга на него в принципе не попадали, но при этом был доступ по прямой ссылке, набрав в строке поиска название именно этого товара, то есть по низкочастотному запросу.

-

Вы можете использовать архивные карточки для профита от перелинковки.

При этом если товар в принципе не планируется к поступлению или отсутствует более 90-100 дней, имеет смысл настраивать 301-редирект на наиболее близкий аналог. Есть и другой кейс — можно настроить 404-страницу, а когда товар появляется, страница снова начинает отдавать 200 ОК. Это негативный опыт для поисковой системы — привлечение трафика на такие карточки, как правило, подрезано и уменьшено относительно такой стратегии.

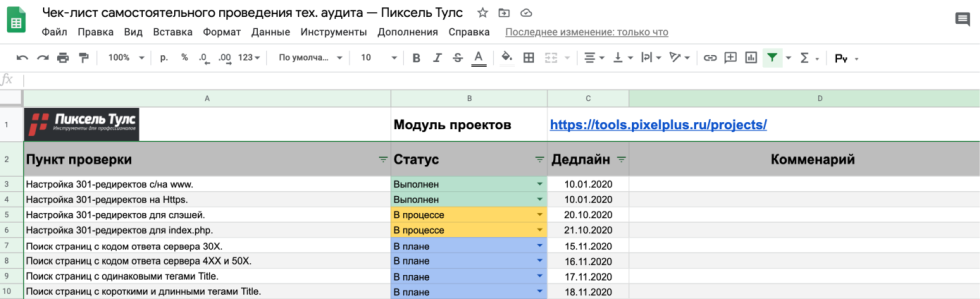

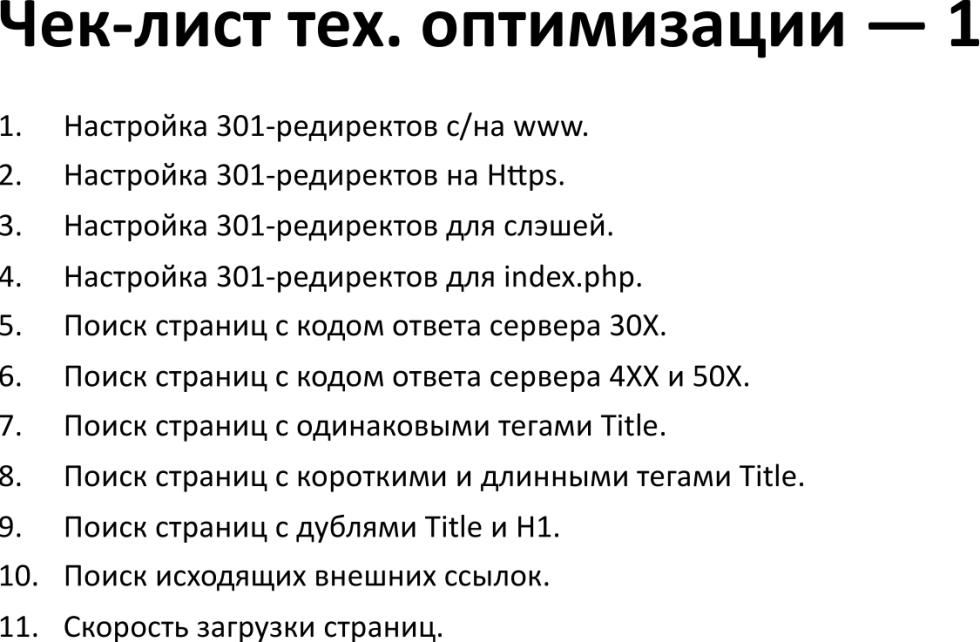

Вспомогательные материалы и полезные ссылки

-

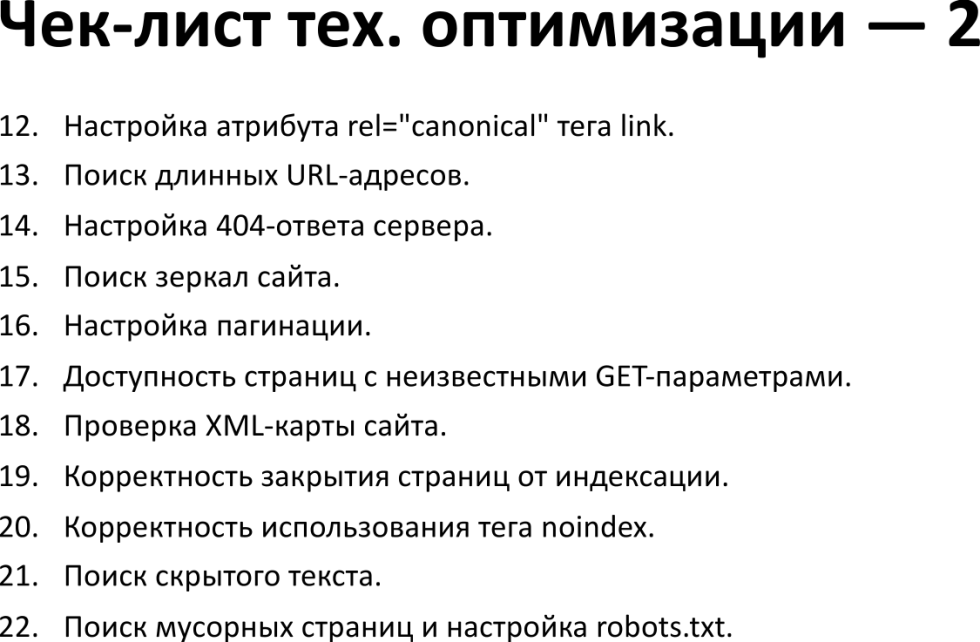

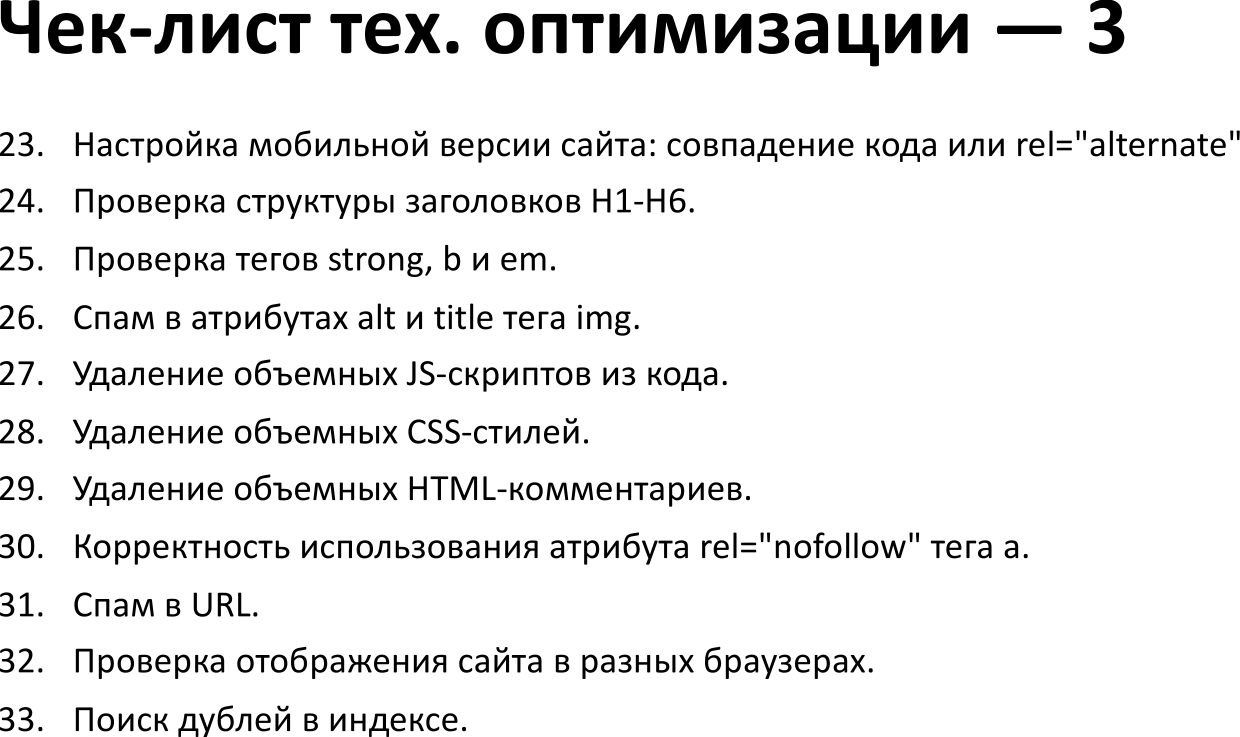

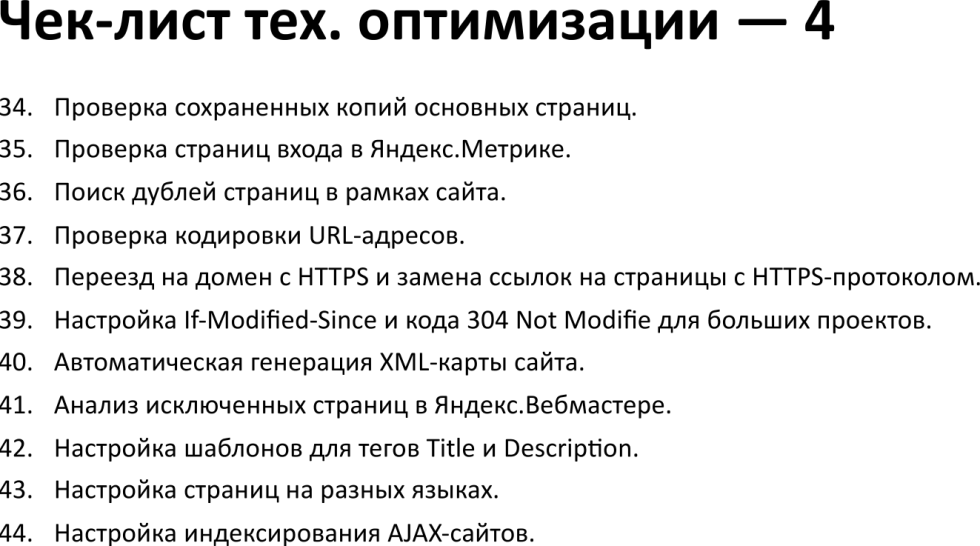

Чек-лист по проведению технического аудита: https://bit.ly/pixeltools-checklist.

Вы можете его себе скопировать. Здесь 44 пункта, которые мы подробно разобрали на двух последних вебинарах, посвященных технической оптимизации сайта.

Здесь вы можете оставлять комментарии, устанавливать дедлайны, выставлять соответствующий статус: выполнен, в процессе, в плане.

-

Работа с региональными вариациями факторов ранжирования под Яндекс

-

Как провести аудит контента и увеличить органический трафик?

-

Исследование по 5,2 млн. десктопных и мобильных страниц, что влияет на PageSpeed

-

Регулярный и массовый поиск проблем с поведенческими факторами (Индексация, Аудит, Распределение)

Мы закончили рассмотрение «17 самых популярных задач технической оптимизации сайта: проблемы и решения».

Традиционные вопросы для сертификации

Запись вебинара

Чтобы не пропускать новые материалы, подписывайтесь на наши группу ВКонтакте, чат Telegram и канал YouTube.

Рейтинг статьи:

По оценкам 37 пользователей

Другие материалы